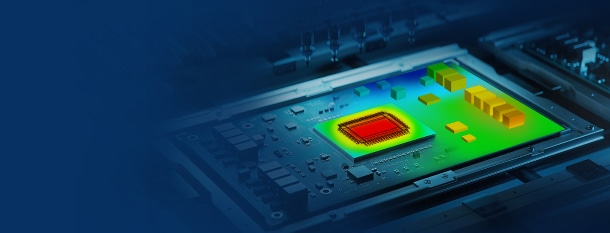

当单核CPU主频触及物理天花板,摩尔定律渐行渐远,工业界却对产品的精细化仿真提出更高要求——千万级、甚至上亿级网格日益成为常态。

传统仿真工具受限于单核CPU主频物理极限,在面对大规模网格的精细化仿真时,往往陷入“算力不足、内存受限、周期冗长”的困境。如何突破单节点限制,驾驭海量网格,实现高效仿真?

云道智造的电子散热仿真软件Simdroid-EC凭借基于MPI的跨节点并行架构,为这一问题提供了创新性解决方案。

一、MPI:从单核到跨节点的算力重构

MPI(Message Passing Interface)是目前最流行的大规模并行编程环境之一。这是一种基于消息传递的并行编程技术,具有出色的可移植性和拓展性,能够实现完善的异步通信,且被众多并行计算机厂商广泛支持。MPI天然支持分布式和跨节点,可以突破单机/单计算节点的CPU核数和内存限制,利用从几台到数万个节点组成的超算的内存和算力,实现大规模问题的加速求解。

Simdroid-EC自架构伊始便采用MPI技术开发,天然支持跨节点计算功能。在进行仿真计算时,先对网格进行分区,然后每个MPI进程加载一块子网格进行计算,从而加速问题求解,提高网格计算规模的上限。

针对MPI计算时常见的负载均衡问题,Simdroid-EC采用网格聚集、边界绑定等方法,尽可能确保每个MPI进程的计算负载均衡。同时,针对散热场景同时出现流体和固体网格的情况,使用优化定制的高效线性处理器求解迭代过程中形成的方程组,可大幅提升求解器的整体性能和计算效率。

二、天河二号实测:30倍性能跃升

Simdroid-EC的跨节点并行计算功能经过了自建集群、云平台、超算中心等多种软硬件环境的测试和验证,并进行了多轮迭代优化,提升了计算效率和鲁棒性,已经在多个商业客户中大规模部署使用。

以在天河二号星逸集群上的测试为例,该集群单节点配备64核CPU和 512G内存。在计算一个4400万网格的服务器风冷模型时,Simdroid-EC使用1024核(16个节点)相较于16核(单节点)实现了将近30倍的加速。这一数量级的性能提升,展示了Simdroid-EC在跨节点功能上的高可拓展性。

三、差异化优势,从“替补”到“主力军”

当前,国际主流热仿真软件在跨节点计算领域存在明显不足:不支持跨节点功能,计算速度或问题规模受单机硬件制约;跨节点功能对硬件要求高,或计算效率较单节点提升不明显。而Simdroid-EC是极少数真正实现跨节点分布式并行的工业级热仿真解决方案。

Simdroid-EC目前已在国内某电子通讯龙头企业实现了对国际主流热仿真软件的规模化替代。以下是来自工程师们对于跨节点并行计算技术的真实使用体验:

“计算很快!快到有时候都来不及找自己的问题。”——热仿真工程师

“比XX平台快多了!再也不用排队等算力!”——热仿真工程师

“没他不行!建议开放256核,多跨一些节点。”——热仿真工程师

“小规格资源算超大模型,性能超出预期!”——云平台开发工程师

立即体验革新性热仿真技术!点击下方小卡片免费试用Simdroid-EC。